Apple 宣佈為了保護兒童,將會在 iOS 15、iPadOS 15、watchOS 8、macOS Monterey 加入全新功能,阻止 Child Sexual Abuse Material (CSAM)傳播。

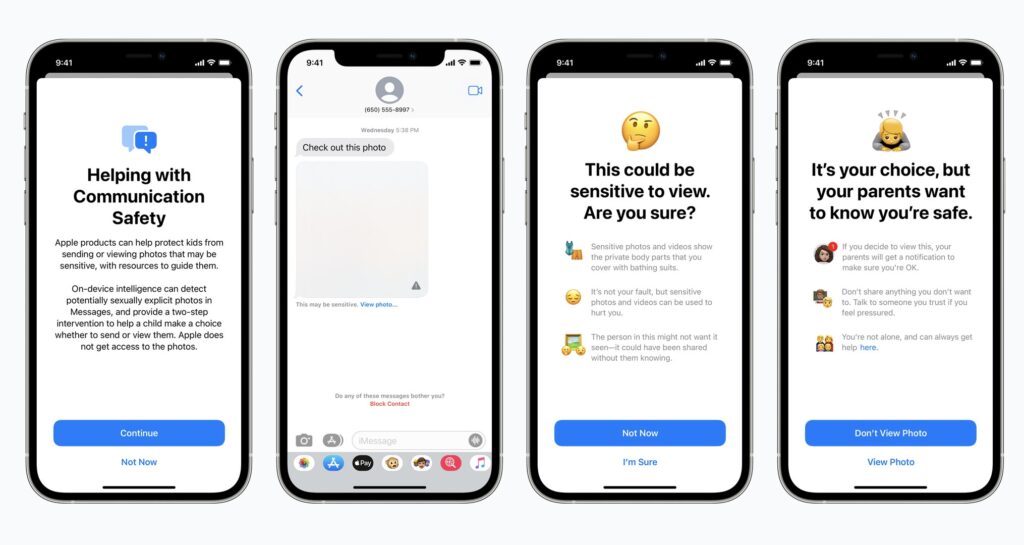

透過 iMessage 阻擋兒童色情內容

首先,iMessage 會使用裝置上的機器學習功能,對任何敏感內容發出警告,當中會保障用戶的私隱,Apple 也不會得知。

若對方向兒童用戶發出色情照片,相關照片將會自動「模糊化」及作出警告,而兒童的家長也會收到有關提示,讓他們得知子女收到相關的照片。同樣,若兒童向任何人透過 iMessage 發出色情照,也會作出警告並通知家長。

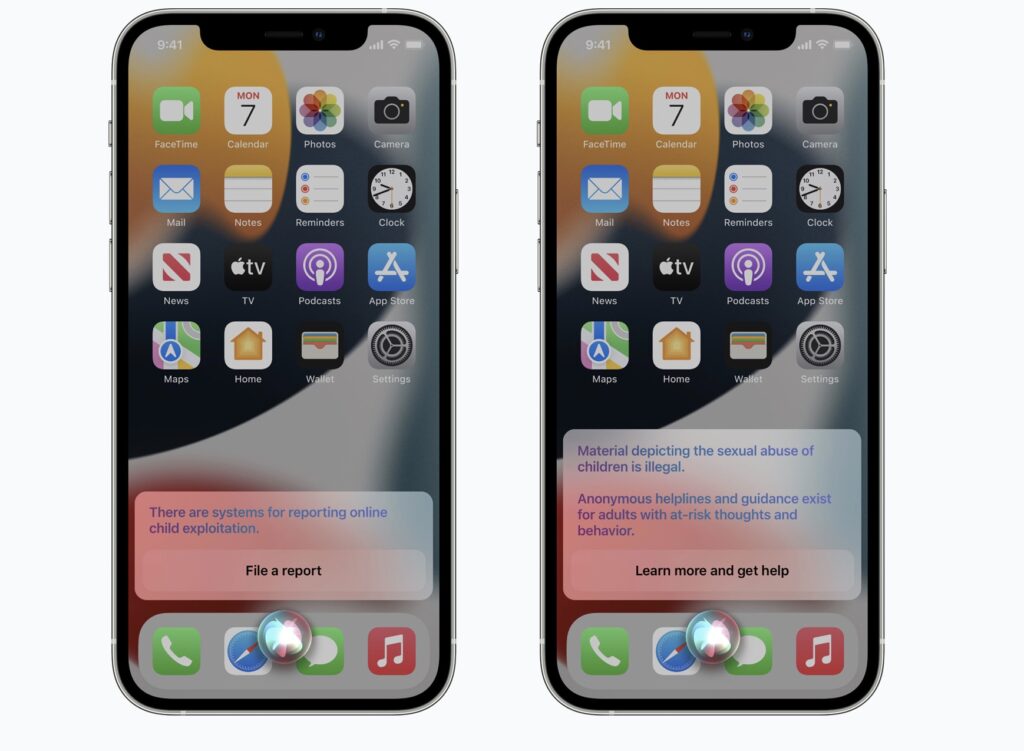

搜尋相關資料會作警告

另外,若透過Siri 及搜尋功能來找 CSAM 兒童色情內容,將會對用戶發出警告。

掃描 iCloud 照片或交失蹤兒童機構

另外,iOS 及 iPadOS 會用新的技術,限制 CSAM 兒童色情內容傳播,同時 Apple 會對 iCloud 上的照片進行偵測,若找到 CSAM 兒童色情內容會將資料交予美國國家兒童失蹤與受虐兒童援助中心,再跟當地執法機構作出研究。暫時,這功能初部會在美國地區啟用,其他地區暫時不會加入。