來自《The Information》報導,微軟自 2019 年起秘密開發自家 AI 晶片,以應對大型語言模型的訓練需求,擺脫對 Nvidia 高昂成本的依賴。一些微軟和 OpenAI 的員工已經開始試用這些晶片,測試它們在最新大型語言模型,如 GPT-4 中的性能。

Nvidia 晶片成本高

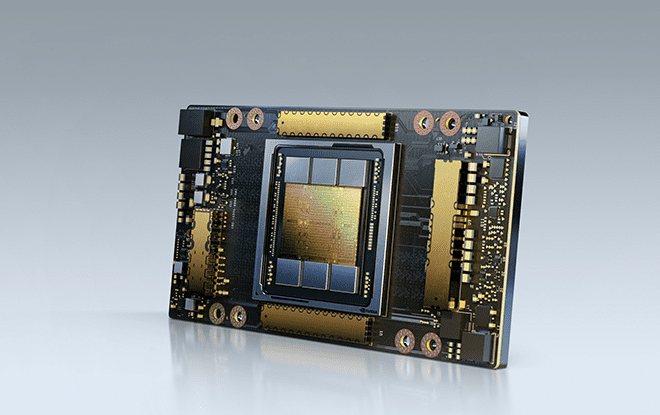

目前,Nvidia 是 AI 伺服器晶片的主要供應商,許多公司爭相購買這些晶片。據估計,OpenAI 在 ChatGPT 的商業化過程中需要超過 30,000 個 Nvidia 的 A100 GPU。Nvidia 最新的 H100 GPU 在 eBay 上的售價超過 40,000 美元,顯示出市場對能有效部署 AI 軟件的高性能晶片的需求。

項目名為 Athena

雖然 Nvidia 正努力滿足市場需求,但報導稱微軟正尋求內部解決方案,希望節省 AI 項目的成本。據報導,微軟已加快代號「Athena」的 AI 晶片開發項目。雖然尚不清楚微軟是否會向 Azure 雲客戶提供這些晶片,但計劃在明年內將 AI 晶片更廣泛地應用於微軟和 OpenAI。而且微軟還對 AI 晶片定好了「路線圖」,未來還會有新一代的版本出現。

降低成本非取替 Nvidia

據稱,微軟自家 AI 晶片並非直接替代 Nvidia 的產品,但內部開發晶片可以大幅降低成本,有助於微軟在 Bing、Office 應用、GitHub 等領域持續推出 AI 功能。