相信,很多人也知道 AI 繪圖最大的「困難」就是人類的手指,如果大家試過叫 AI 生成一個 Give me Five 的手勢,它很可能會出現 6 隻手指。為了解決一些 AI 生成圖的問題,近日 Meta 公佈了一個能夠透過學習識別圖像,並建立相關知識的計算視覺模型,使人工智能操作更流暢,而且降低了成本。

該模型名為「圖像聯合嵌入預測架構」(Image Joint Embedding Predictive Architecture,簡稱 I-JEPA),其工作原理是建立外部世界的內部模型,然後比較圖像的抽象表現,而非直接比較像素。

據 Meta 在其網誌上解釋,I-JEPA 在多種計算視覺任務上表現出強大的效能,並且比其他廣泛使用的計算視覺模型在計算效率上有著顯著的優勢。在 72 小時內,Meta 利用 16 顆 Nvidia A100 GPUs 訓練出了一個具有 6.32 億參數的視覺轉換模型。該公司聲稱,這種模型在使用 ImageNet 數據集進行低樣本分類時,比其他方法(如 Data2vec、Context Autoencoders 和 Masked Autoencoders)有更好的效果。

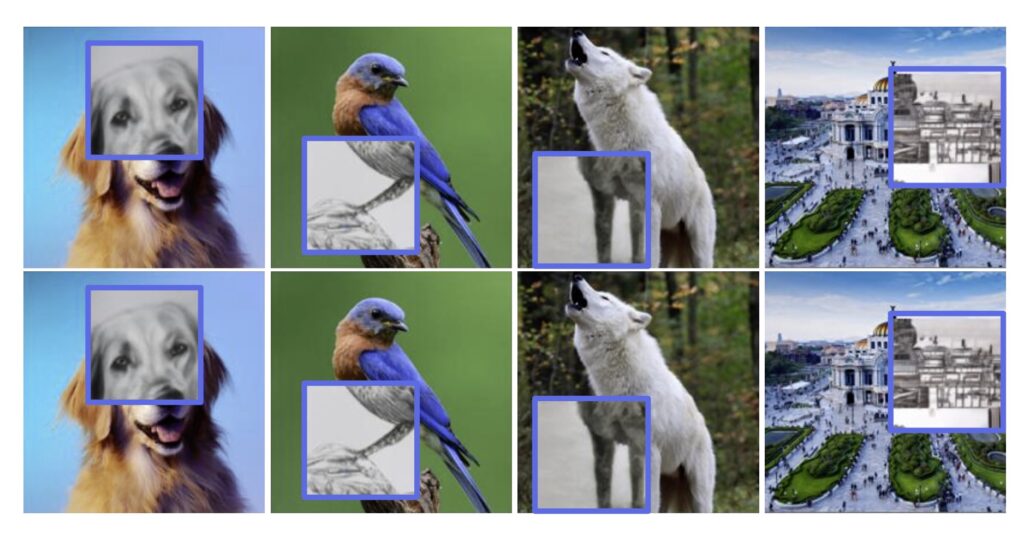

Meta 稱,與其他的自我監督學習方法相比,I-JEPA 需要更少的 GPU 訓練時間,並且在相同數據量下,其錯誤率更低。Meta 的科學家(包括著名的 AI 先驅 Yann LeCun)在一篇名為「自我監督學習的圖像聯合嵌入預測架構」的論文中解釋,I-JEPA 是通過嘗試預測圖像部分區域中的缺失信息來工作的。此模型操作的區塊足夠大,足以傳達語義細節,賦予圖像片段更多的意義。由於這些片段能傳達它們相鄰區塊的相關信息,模型可以利用這些信息進行更精確的預測。

I-JEPA 的結果顯示,生成圖像時較不容易出錯——例如創建有多餘手指的手。Meta 表示,這是因為生成架構嘗試在沒有場景概念基礎的情況下填充每一個信息,因此在處理人手時常會出現問題。

科學家們稱,I-JEPA 展示了一種學習競爭性的現成圖像表現的架構的潛力。I-JEPA 已經以Creative Commons Attribution-NonCommercial 4.0 International Public License 發布。